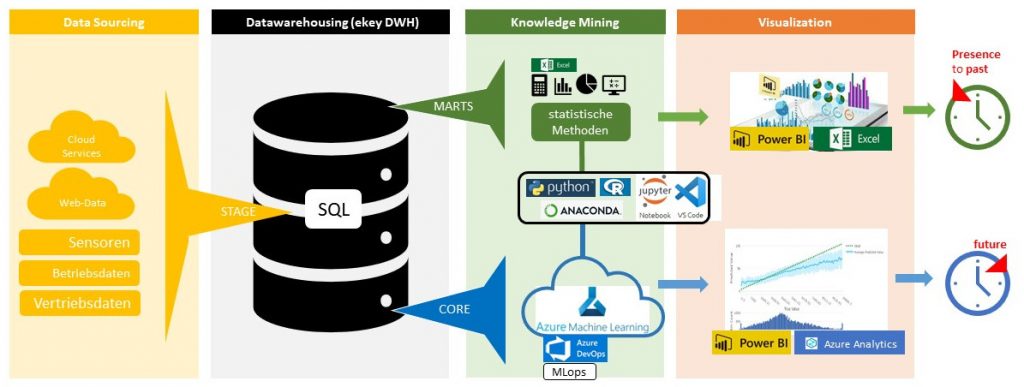

Data Governance, Datenmanagement, Data Science eine Unmenge an Begriffen schwirrt durch das World Wide Web (www), um den Umgang mit digitalen Assets – wie Daten auch genannt werden – zu beschreiben. Obwohl unterschiedlich genannt, sind die Grenzen der Bedeutung verwischt nicht immer eindeutig. Wesentlich ist, dass hinter den Begriffen ein Prozess steht. Ein Prozess der definiert wie Daten erhoben, bereinigt, verdichtet, gespeichert, genutzt, geteilt, gelöscht werden. Das Wichtigste ist aber, wie aus all den Daten Wissen gewonnen wird, welches dann für die Geschäftsmodellierung, für Organisationsänderungen, für Strategieentscheidungen genutzt wird. Ich habe hier einmal versucht diesen Prozess darzustellen:

Sieht kompliziert aus, oder? Ich kann sie nicht beruhigen: Es ist kompliziert! Datenmanagement ordentlich und zielführend zu betreiben ist alles andere als eine einfache Aufgabe. Das Dilemma dabei ist nämlich, dass man sich wenig bis keine Kompromisse leisten kann. Entweder man macht es und dann konsequent, professionell, wissenschaftlich, mit hohem Qualitätsanspruch oder man lässt es sein. Ein „bisschen“ Data Science oder Data Management gibt es nicht bzw. bringt es meist nicht die gewünschten Verbesserungen! Denn der Kern des Arbeitens mit Daten ist es Subjektivität aus der Geschäftsprozessen und Managemententscheidungen weitgehend zu eliminieren und das in allen Fachbereichen des Unternehmens. Objektiv und ehrlich sollen die Daten den Zustand des Unternehmens bzw. der Organisation zeigen damit einen Blick in die Zukunft vereinfachen und die Basis für möglichst korrekte Managemententscheidungen liefern. Macht man das nicht mit ausreichender Qualität, bekommt man die Subjektivität nicht vom Tisch und schafft wenig an Wissen, wenig an Inputs für Organisationsänderungen und für neue Geschäftsmodelle.

Man muss also den Prozess des „Data Governance“ im Unternehmen eindeutig verankern und Zuständigkeiten klar definieren. Dann und nur dann werden sie Nutzen daraus ziehen. Und verabschieden sie sich davon, dass das eine Person macht! Datenmanagement ist eine Querschnittsaufgabe, nein eigentlich eine Denkweise der Digitalisierung, die sie in allen Unternehmensbereichen verankern müssen. Data Manager oder Data Scientists sind nur die Verantwortlichen, die die Infrastrukturen aufrecht erhalten. Interpretieren, bewerten und nutzen müssen die Daten und das daraus gewonnene Wissen die Manager und verantwortliche Mitarbeiter in den Fachbereichen, und dazu braucht es auch den Überblick über die relevanten Data Sets, die Erfahrung mit Werkzeugen diese zu erheben, zu bereinigen und zu verarbeiten.

Machen wir grob einen Blick auf die Prozessstruktur im Datenmanagement, schauen wir uns die einzelnen Domänen einmal ganz grob an:

- Data Sourcing

- Datawarehouse

- Knowledge Mining

- Visualisation

Data Sourcing

Wann immer in der digitalen Welt Informationen zwischen Menschen, zwischen Maschinen oder auch zwischen Mensch und Maschine ausgetauscht werden, sind das Daten, die im Sinne des Data Governance genutzt werden können. Jeder Geschäftsprozess, sei es ein Produktionsprozess, ein Prozess in der Buchhaltung, ein Nachhaltigkeitsprozess erzeugt digital Daten, welche in unterschiedlichsten Speicherorten, wie Datenbanken strukturiert als auch unstrukturiert abgelegt werden. Jeder dieser Speicherorte, wie Datenbanken, Excellisten, Laufwerksordner, Datenfiles usw. sind potentielle Datenquellen für das Datenmanagement, für Data Science. Ja und wenn man das so liest erahnt man die Problemstellungen mit denen man im Data Governance kämpft. Denn schon die Datengewinnung und Ablage muss durchdacht sein, die Daten müssen eine definierte Qualität besitzen, damit man Wissen daraus gewinnen kann. Data Engineers kümmern sich darum. Sie sorgen dafür, dass die Datenquellen sinnvolle, verarbeitbare Daten liefern und speichern. Und das ist kein einfaches Unterfangen, denn wie viel wurde denn in den letzten 10 Jahren an die Datenprozesse gedacht? Wenig bis gar nicht. Da gab es Absatzzahlen, Umsatzzahlen und Kostenaufstellungen aus der Buchhaltung die ordentlich und strukturiert erfasst wurden. Aber recht viel mehr nicht. Der Rest liegt meist unstrukturiert vor, wobei jede Abteilung oder Fachbereich eigene Datenstrukturen geschaffen und dabei wenig an die Verbindung zu den Daten anderer Fachbereich gedacht hat. Ein Datenquellenfleckerlteppich, der viel Arbeit braucht, um die darauf aufbauenden fachbereichsübergreifende Prozesse der Wissensgewinnung anstoßen zu können, die aber genau heute den Unterschied ausmachen. (Mehr… folgt)

Data-Warehousing

Viele genießen es wohl heute in ein großes Einkaufszentrum zu fahren und einzukaufen. Man weiß, dass man praktisch alle notwendigen Dinge an einem Ort findet. Man kennt den Weg zum Einkaufszentrum, kennt das Parkhaus und den Ort an dem die Einkaufswägen zu finden sind und überall ist Kreditkartenzahlung möglich. Ein Datawarehouse ist nichts anderes. Ein Dateneinkaufszentrum, an dem alle wichtigen Daten im Unternehmen zu finden sind, spezielle aufbereitet für die nachfolgenden Nutzer. Es gibt eine Datenstraße (Datenschnittstelle) dorthin und man findet die Daten strukturiert und normiert (innerhalb des Unternehmens) vor. Sie sind sofort weiter verarbeitbar und können so ihren Nutzen für den Anwender schaffen. Genau das ist die Kernaufgabe eines Datawarehouses. Es soll Daten aus den verschiedensten strukturierten und unstrukturierten Datenquellen einlesen, bereinigen (ungültige, fehlerhafte Datensätze ausscheiden), aufbereiten und über definierte Datenschnittstellen zur Verfügung stellen. Data Engineer und Data Manager (In kleineren Unternehmen ist es auch eine Person) arbeiten zusammen und bauen das Warehouse, dass auch einer standardisierten Bauplan (Staging – Cleansing – Core – Marts) aufweist und so in sich meist für ein neues Verständnis im Unternehmen im Umgang mit Daten führt. (Mehr … folgt)

Knowledge Mining

Jetzt wird es wirklich interessant. Jetzt schürfen wir aus den Datenmengen, die an der Datenquelle entstehen und im Datawarehouse bereinigt und aufbereitet wurden Wissen. Die Mathematik- genaugenommen statistische (stochastische) Methoden- ist hier das Werkzeug das uns erlaubt den Status mit Kennzahlen zu jedem Zeitpunkt zu definieren. Viel wichtiger ist es aber Prognosen über die Geschäftsentwicklung, Verkaufsentwicklung usw. anzustellen. Auch das ist mit der Stochastik möglich, wenngleich hier auch die künstliche Intelligenz Einzug hält und dort und da schon heute hervorragendes leistet. Hier ist es nicht angebracht zu sparen! Alles Datenmanagement, alles speichern, alles Verarbeiten ist wertlos, wenn sie nicht das Wissen aus den Daten schürfen. Daten zu speichern kostet Geld, wenn sie die Daten nicht nutzen, werfen sie Geld zu Fenster raus. Das ist schlimm aber noch viel schlimmer ist es, dass sie ohne Wissensgewinnung aus Daten Trends und Markveränderungen nicht erkennen und letztlich falsche Entscheidungen treffen. Ein Mitbewerber mit professionellem Knowledge Mining wird dann schneller sein und sie werden verlieren, zumindest aber in Rückstand geraten.

Visualisation

Der Darstellung von Daten kommt in heutigen Unternehmen eine unglaublich wichtige Bedeutung zu. Einfach und schnell erfassbar müssen die Daten für die jeweiligen Stakeholder sein und das muss auch möglichst automatisiert werden. Den niemand hat heute zeit sich durch Listen zu wühlen. Auf Knopfdruck muss man das Wissen abrufen können. Business Intelligence nennt man die Werkzeuge, die es heute erlauben Liniendiagramme, Histogramme, Zeitreihen usw. für unser Gehirn einfach erfassbar darzustellen. Ich arbeite viel mit Microsoft PowerBI, weil es auch eine einfache Verbindung auch zu den Office-Programmen und auch zu Microsoft Azure herstellen kann. Aber es gibt natürlich auch andere Werkzeuge, wie z.B. Tableau. Der Darstellung der Daten kommt besonders bei Managemententscheidungen eine große Bedeutung zu. Je besser und klarer das Wissen aus den Daten dargestellt wird, umso einfacher wird es für die Manager auch Entscheidungen zu treffen. Schlechte, unvollständige, wenig relevante Daten führen meist zu endlosen Diskussionen und damit verliert man Zeit. Und Zeit ist Geld, oder besser Geschwindigkeit ist Geld. Je schneller man auf Markveränderungen reagieren kann umso größer wird die Chance auf Erfolg.

FAZIT

Daten wirklich nutzen und sie als prediktive, taktische und strategische Entscheidungsgrundlage (faktenbasierte Entscheidungen) zu nutzen, braucht Excellence in allen Dimensionen des Data Governance. Auch wenn man zu Beginn die einzelnen Fachbereiche (sukzessive) auf die neue Denkweise der datengetriebenen Unternehmensführung umstellen muss, am Ende muss das gesamte Unternehmen dabei sein. Zumindest muss das das Ziel sein, sonst gibt es weiter viel Diskussionsbedarf und schlaflose Nächte. Den ein funktionierendes Data Governance schafft am Ende ein Management mit wenig bis keinen kognitiven Dissonanzen.

Data Manager, Requirements-Engineer, Business Manager, Data-Scientist, Business Model Designer, Compliance Manager, Innovator, Sachverständiger, Allrounder

+43 660 / 24 02 033